Laura Stier

Kognitive Tests galten jahrelang als Vorreiter im Hinblick auf ihre prognostische Validität

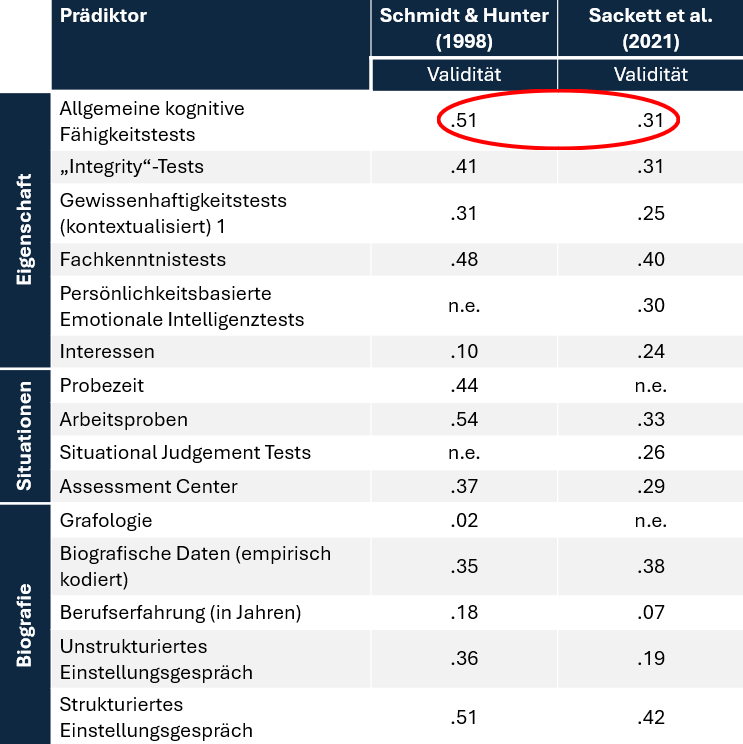

Die Durchführung kognitiver Testverfahren ist im Rahmen der beruflichen Eignungsdiagnostik häufig das Mittel der Wahl, um gezielte Aussagen über die Eignung beziehungsweise das Potenzial einer Person für eine bestimmte Rolle treffen zu können. Dies liegt unter anderem daran, dass kognitive Testverfahren mit relevanten Erfolgskriterien wie der beruflichen Leistung zusammenhängen. Die wohl bekannteste und einflussreichste Metaanalyse, welche sich unter anderem mit der Validität kognitiver Testverfahren befasst, ist jene von Schmidt und Hunter (1998). In ihrer umfassenden Metaanalyse ermitteln sie einen großen Zusammenhang zwischen den Ergebnissen kognitiver Testverfahren und der beruflichen Leistung von r = .51. Hinsichtlich der Validität standen kognitive Testverfahren somit jahrelang ganz weit oben. Auch wenn die durch Schmidt und Hunter (1998) ermittelten Validitätskoeffizienten mittlerweile als überschätzt gelten, so zeigen auch neuere Metastudien beispielsweise von Salgado et al. (2003) immerhin noch Korrelationen in Höhe von r = .24. Sackett et al. (2021), welche die empirischen Ergebnisse der Metaanalyse von Schmidt und Hunter (1998) noch einmal sorgfältig unter die Lupe nehmen, integrieren in ihre Analyse ebenfalls neuere Studienerkenntnisse, passen Minderungskorrekturen an und analysieren die Auswirkungen unterschiedlicher Formen der Varianzeinschränkung systematischer. Daraus resultiert eine vermutlich realistischere Validität der kognitiven Testverfahren in Bezug auf die Arbeitsleistung in Höhe von r = .31 (Sackett et al., 2021). Obwohl die Ergebnisse der Validitätsberechnungen in neueren Studien geringer ausfallen als in der Metastudie von Schmidt und Hunter (1998), so lässt sich dennoch festhalten, dass kognitive Tests auch im Vergleich zu anderen Assessment Center Bestandteilen eine hohe Vorhersagekraft in Bezug auf Arbeitsleistung und Führungspotenzial haben. Dies rechtfertigt, insbesondere in Kombination mit weiteren Testverfahren oder AC-Bausteinen, den Einsatz kognitiver Testverfahren im Rahmen der beruflichen Eignungsdiagnostik.

Der KTK-N als business-nahes Instrument zur Erfassung kognitiver Fähigkeiten

Es gibt meist einen Gegensatz zwischen der Prognosestärke von kognitiven Testverfahren für Job- und Führungserfolg einerseits und subjektiver Attraktivität auf Seiten der Teilnehmenden. Die Teilnahme an einem kognitiven Test ist potenziell bedrohlich für die Selbstwirksamkeit, hier begibt man sich in eine fremdgesteuerte Situation mit ungewissem Ausgang und Zeitdruck. Klassische Intelligenzitems (z. B. Zahlenreihen fortsetzen, Würfel drehen) haben per Augenschein nichts mit den spezifischen Jobanforderungen zu tun.

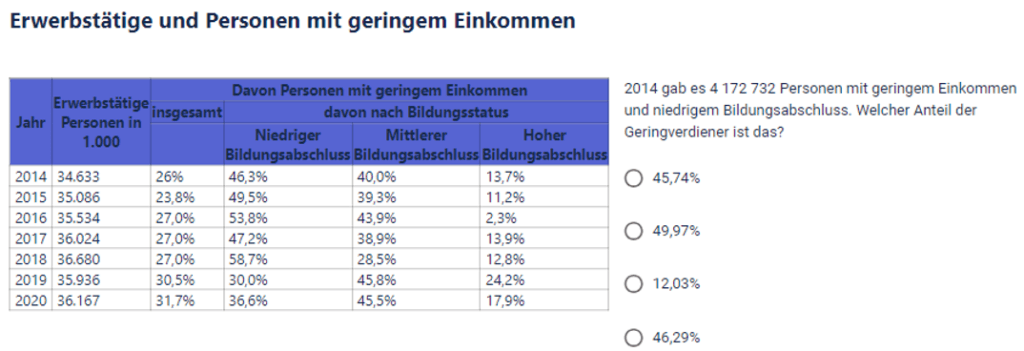

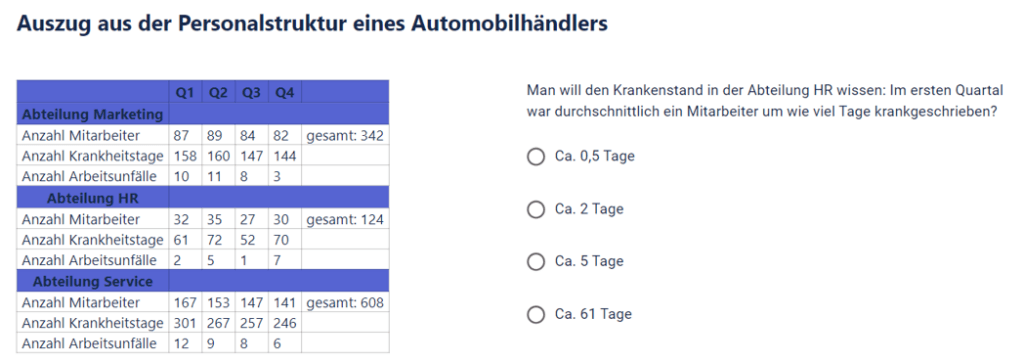

Mit dem Kölner Test zu kognitiven Kompetenzen (KTK-N) liegt ein inhouse entwickeltes und bereits seit vielen Jahren sehr erfolgreich eingesetztes Testverfahren zur Erfassung numerischer kognitiver Fähigkeiten vor. Die Augenscheinvalidität des Tests ist als hoch anzusehen, da die Items Analyseaufgaben zu betrieblichen oder wirtschaftsnahen Tabellen darstellen, die so oder so ähnlich in sehr vielen beruflichen Tätigkeiten vorkommen.

Dazu zählen das schnelle Erfassen wesentlicher und relevanter Inhalte aus zahlenbezogenen Materialien, das Anstellen von Vergleichen möglicher Antwortalternativen, die Herstellung von Relationen, mathematische Kompetenzen, die Fähigkeit zum abstrakten Denken sowie zur Prognosebildung, logisches Schlussfolgern und grundlegende Kenntnisse in wirtschaftswissenschaftlichen sowie ökonomischen Kontexten. Der Test besteht aus 20 Items, welche in einem Zeitrahmen von 40 Minuten bearbeitet werden müssen. Abbildung 1 und 2 präsentieren zwei exemplarische Beispielfragen des KTK-N. Die wesentliche Besonderheit des KTK-N liegt darin, dass die Items einen konkreten Berufsbezug aufweisen. Die meisten kognitiven Testverfahren sind nämlich weniger berufsbezogen konstruiert (bspw. Vervollständigen von Zahlenreihen, Matrizentests) und zielen eher auf einzelne Eigenschaften (z. B. Konzentrationsfähigkeit) ab (Brooklynmaxx, 2020). Durch die damit verbundene vorhandene Augenscheinvalidität des Tests, welche dadurch deutlich wird, dass die erhobenen berufsbezogenen Eignungsmerkmale für die Teilnehmenden ersichtlich sind, erfreut sich der KTK-N einer hohen Beliebtheit bei Kandidatinnen und Kandidaten eignungsdiagnostischer Prozesse. Der Test liegt sowohl in einer klassischen Papier-Variante als auch in einer onlinegestützten Variante vor, welche ebenfalls eine vollständig automatisierte Ergebnisauswertung und Interpretation ermöglicht.

Darüber hinaus liegt der KTK-N auch in einer Branched-Testing-Version vor. Dabei wird der Testablauf dynamisch an die Testperson angepasst. Im Rahmen dieser Testversion werden je nach den bisherigen Ergebnissen unterschiedliche Fragen oder Aufgaben präsentiert. Das verfolgte Ziel ist es dabei, den Test individuell auf die Fähigkeiten des Teilnehmenden zuzuschneiden, um so genauere Ergebnisse zu erhalten. Diese Variante lässt sich zudem als zeiteffizient beschreiben, da die teilnehmende Person nicht alle Items bearbeiten muss und der Test somit schneller abgeschlossen wird.

Uneinigkeit hinsichtlich der Vergleichbarkeit von Papier- und Online-Testungen in bestehender Forschung

Eine Vielzahl an vorliegenden Forschungsarbeiten bestätigen umfassende Vorteile onlinegestützter Testdurchführungen im Vergleich zur Papier-Variante. So überzeugen Online-Testungen durch die hohe räumliche und zeitliche Flexibilität in der Durchführung (Steiner, 2009). Auch hinsichtlich der Feedbackgeschwindigkeit sind Online-Tests, in welchen die Auswertung meist automatisiert erfolgt, der Papierversion überlegen, im Rahmen derer die händische Auswertung durch einen menschlichen Assessor viel Zeit in Anspruch nimmt (Schmidt-Atzert, et al., 2021). Weiterhin minimiert die Abwesenheit eines menschlichen Assessors bei Durchführung und Auswertung der Testung die Gefahr einer möglichen Diskriminierung einzelner Personen(-gruppen). Dadurch wiederum steigt die Akzeptanz aufseiten der Teilnehmenden in Bezug auf die Durchführung von Online-Testverfahren (Steiner, 2009; Krause, 2017). Jedoch sollten auch mit der onlinegestützten Durchführung einhergehende Risiken weiter berücksichtigt werden. Beispielsweise besteht bei nicht kontrollierten Durchführungen die Gefahr, dass Teilnehmende sich externe Unterstützung für die Bearbeitung des Testverfahrens heranziehen, wodurch die Testergebnisse verfälscht werden.

Dennoch lässt sich bestehender Literatur kein einheitlicher Konsens darüber entnehmen, ob die gewonnenen Ergebnisse aus papier- und onlinegestützten Testverfahren wirklich vergleichbar sind. So zeigen sich in einigen Studien keine signifikanten Leistungsunterschiede bei der Durchführung von papier- und onlinegestützten Testverfahren (u.a. Ruiz et al., 2019; Priscari, 2017) während einige Forschungsarbeiten darauf hinweisen, dass die Ergebnisse nicht vergleichbar sind und die Leistung der Teilnehmenden in der Papier-Version höher ist (u.a. Clariana & Wallace, 2002; Bunderson, 1989; Mead & Drasgow, 1993). Es besteht somit akuter weiterer Forschungsbedarf, um validere Aussagen hinsichtlich der Vergleichbarkeit der beiden Durchführungsvarianten kognitiver Testverfahren zu treffen und diese Erkenntnisse für die Praxis nutzen zu können.

Psychologische Unterschiede zwischen online- und papiergestützten kognitiven Testverfahren

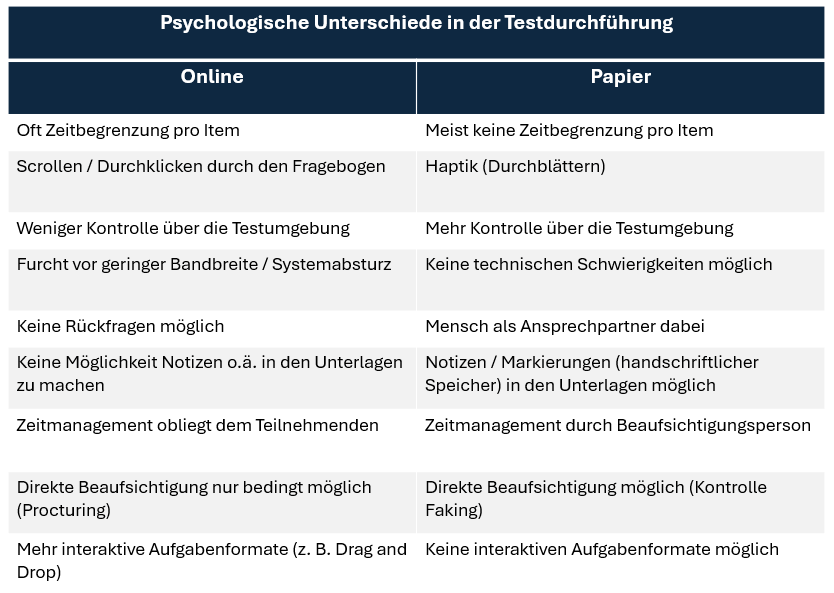

Doch was genau sind psychologische Unterschiede der beiden Durchführungsarten kognitiver Tests, welche wohlmöglich auch einen Einfluss auf die Teilnehmenden und somit auch auf die erzielte Ergebnishöhe haben könnten? Tabelle 2 fasst die wesentlichen Unterschiede zusammen. Zum einen liegt ein Unterschied in der Zeitbegrenzung pro Item, welche in einer Online-Durchführung wesentlich leichter umzusetzen ist und die Teilnehmenden in der Bearbeitung des Testverfahrens stärker steuert. Ein weiterer Unterschied ist die physische Umgebung, welche sich in der papiergestützten Variante durch mehr Haptik (Durchblättern durch die Seiten) auszeichnet, während in der onlinegestützten Durchführung die Probanden durch den Fragebogen scrollen müssen oder sich durchklicken. Insgesamt haben die Teilnehmenden in der Papier-Variante eine größere Kontrolle über die Testumgebung als in der Online-Variante, da sie die Bearbeitung beispielsweise selbst steuern können und keine Befürchtungen hinsichtlich technischer Schwierigkeiten (geringe Bandbreite / Systemabsturz) und damit verbundenen Konsequenzen haben müssen. Zudem ist es in der Papier-Variante möglich, jederzeit Rückfragen zu stellen, was in einer Online-Testung ebenfalls nicht oder nur sehr bedingt möglich ist. Weiterhin können die Testunterlagen in der Papier-Variante beispielsweise markiert oder handschriftliche Notizen hinzugefügt werden, was die Bearbeitung möglicherweise erleichtert. Dies ist in der Online-Variante nicht oder nur auf einem externen Blatt Papier möglich. Auch das Zeitmanagement, welches in der Online-Variante allein dem Teilnehmenden obliegt, stellt einen weiteren wichtigen Aspekt dar. Auch dies ist ein Aspekt, welcher wohlmöglich mehr kognitive Ressourcen der Teilnehmenden erfordert, als wenn der menschliche Ansprechpartner vor Ort einen gewissen Anteil am Zeitmanagement hat. Die direkte Beaufsichtigung, welche im Rahmen der papiergestützten Version möglich ist, ermöglicht es weiterhin Faking der Teilnehmenden direkt zu kontrollieren und zu unterbinden. In der Online-Version ist dies nur durch spezifische Procturing-Mechanismen möglich, wodurch oftmals die Möglichkeit besteht, beispielsweise durch die Unterstützung einer weiteren Person, die Testergebnisse zu verfälschen. Ein letzter wesentlicher Aspekt, welcher für die Teilnehmenden einen Unterschied zwischen Online- und Papier-Testung darstellt, ist die Form der Aufgabenformate. Während in der Online-Testung diverse, auch interaktive Aufgabenformate (z. B. Drag and Drop) möglich sind, besteht in der Papier-Testung nicht die Möglichkeit interaktive Aufgabenformate einzufügen. Das Testumfeld ist nicht dynamisch und es sind somit nur statische Aufgabentypen möglich.

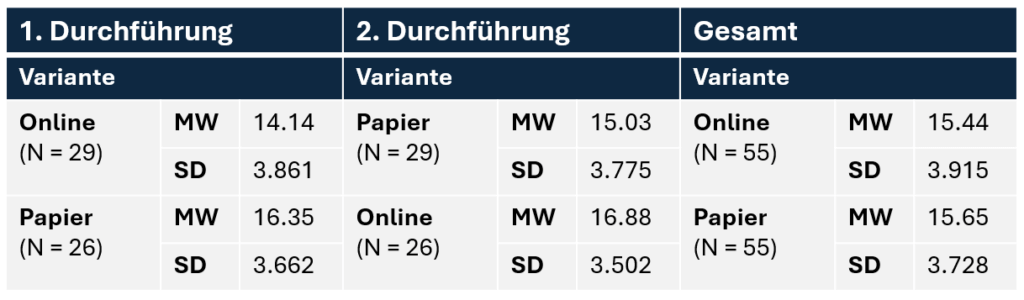

Wenn zuerst die Papiervariante bearbeitet wird, erzielen die Teilnehmenden bessere Testergebnisse

Eine aktuelle Forschungsstudie beschäftigt sich mit den Unterschieden zwischen papierbasierten und onlinebasierten kognitiven Tests (Becker, 2025). Die Studie identifiziert einen signifikanten Unterschied der Testergebnisse je nachdem, ob die Probanden zunächst die Online- oder Papier-Variante des KTK-N bearbeiteten. Wie bereits die deskriptiven Daten in Tabelle 3 erahnen lassen, sind die Testergebnisse der zweiten Testung signifikant besser, wenn die Teilnehmenden zuerst die Papier-Variante des KTK-N bearbeiten. Als mögliche Erklärung wird dafür der direkte Testungseffekt herangezogen. Die physische Interaktion im Rahmen der Papier-Testung liefert die Möglichkeit, bessere Gedächtnisspuren zu bilden, was wiederum zu besseren Ergebnissen führen kann. Eine weitere Begründung für das Ergebnis könnte die geringere extrinsische kognitive Belastung bei der Durchführung auf Papier darstellen, da die Teilnehmenden hier jederzeit physische Kontrolle über das Material haben und weniger kognitive Ressourcen für die Navigation und Kontrolle der Testumgebung benötigt werden. Dadurch ist es den Teilnehmenden möglich, sich besser auf die dargebotenen Aufgaben zu konzentrieren. Die nachträgliche Adaption auf das Online-Testformat, nachdem der Test aus der Papier-Durchführung bereits bekannt ist, ist somit vorteilhaft für die erzielte Ergebnishöhe (Becker, 2025). Aber auch grundlegend sind die Ergebnisse der ersten Testung, wie sich Tabelle 3 entnehmen lässt, in der Papier-Version besser.

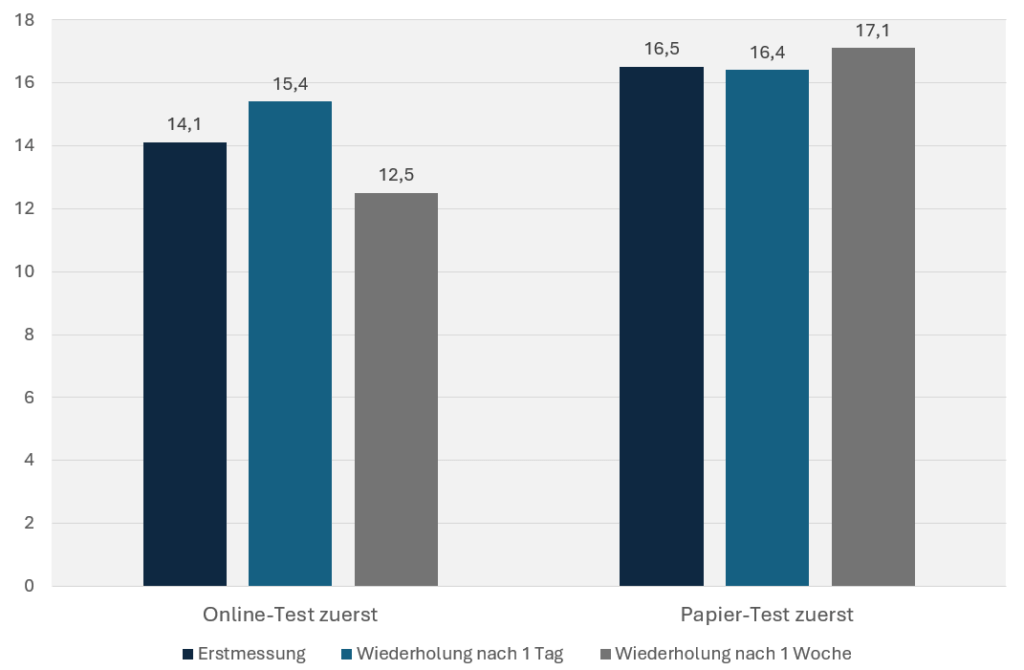

Zeitraum bis zur erneuten Testwiederholung hat keinen Einfluss auf die Ergebnisse der Teilnehmenden

Eine weitere spannende Erkenntnis der Studie ist, dass eine erneute Testwiederholung keinen Einfluss auf das erreichte Testergebnis hat und die Leistung durch eine erneute Testdurchführung somit nicht weiter gesteigert werden kann. Dies widerlegt die aufgestellte Hypothese, dass die Teilnehmenden ihr gesammeltes Wissen und ihre Erfahrungen aus der ersten Testung nutzen und dadurch bessere Ergebnisse in der zweiten Testung erzielen. Eine mögliche Erklärung dafür liefert die Annahme, dass Teilnehmende bereits bei der ersten Testung ihre maximale Leistungsfähigkeit abrufen und daher ihre Leistung in der zweiten Testung nicht signifikant steigern können (Becker, 2025). Es lässt sich jedoch auch beobachten, dass die Leistung bei wiederholter Testung teilweise sogar sinkt. Dies könnte möglicherweise an einer mangelnden Testmotivation liegen, da die Teilnehmenden sich nicht in einer realen Bewerbungssituation befanden und die Testergebnisse keinerlei Konsequenzen mit sich zogen.

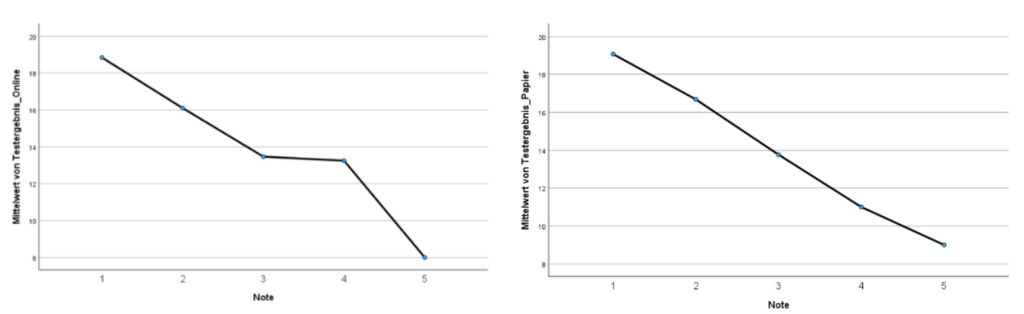

Signifikante Zusammenhänge zwischen Testergebnissen und der Mathematik- / Statistiknote

Die Studie identifiziert signifikante Zusammenhänge zwischen dem Testergebnis des KTK-N und der letzten Mathematik- / Statistiknote der Teilnehmenden. Wie sich ebenfalls Abbildung 4 entnehmen lässt, nimmt das Testergebnis ab, je schlechter die Mathematik- bzw. Statistiknote der Teilnehmenden ist (Becker, 2025).

Es wird ersichtlich, dass sich dieses Phänomen sowohl bei der onlinegestützten als auch bei der papierbasierten Durchführungsart beobachten lässt (Abbildung 3). Insbesondere die Noten 1 und 2 der deutschen Notenskala bewirken eine positive Entwicklung der Testergebnisse der Teilnehmenden. Es wird angenommen, dass die Mathematik- bzw. Statistiknote eines Teilnehmenden einen Indikator für den wahren Testwert darstellt, da Personen mit einer guten Note über längere Zeit hinweg gute Leistungen in diesem Fach erbracht haben, was wiederum auf die grundlegende mathematische Fähigkeit der Person zurückzuführen ist. Weiterhin führt die durch eine gute Note bestehende Affinität für Zahlen sowie die Fähigkeit Zahlen und Daten korrekt zu interpretieren dazu, dass die Bearbeitung der dargebotenen Aufgaben leichter fällt, wodurch das erzielte Testergebnis besser wird (Becker, 2025).

Ergebnisse der unterschiedlichen Durchführungsarten somit nur bedingt vergleichbar

Wie die Studienergebnisse von Becker (2025) verdeutlichen, sind die Ergebnisse aus onlinegestützten und papierbasierten kognitiven Tests nur bedingt vergleichbar. Die Durchführung auf Papier ist für die Teilnehmenden wohlmöglich mit weniger externem kognitivem Aufwand verbunden, weshalb die Testergebnisse besser ausfallen. Dennoch ist die Arbeit an einem Computer in den meisten Berufen mittlerweile alltäglich und unabdingbar, weshalb die Online-Durchführung eher einer alltäglichen Arbeitssituation nahekommt, in welcher die Mitarbeitenden sicher im Umgang mit digitalen Geräten und Online-Umgebungen sein müssen. Diese Erkenntnis berücksichtigend, sollten Unternehmen die Durchführungsart der kognitiven Testverfahren wohl überlegen und entsprechend der jeweiligen Anforderungen umsetzen.

Fazit

Es lässt sich festhalten, dass kognitive Testverfahren auch weiterhin als prognosestark in Bezug auf zukünftigen Berufserfolg angesehen werden können. Damit kognitive Testverfahren eine höhere Akzeptanz von Teilnehmenden erfahren, empfiehlt es sich diese möglichst berufsbezogen zu konstruieren. Durch einen erkennbaren Bezug der Items zu konkreten Jobanforderungen wird die Augenscheinvalidität und damit einhergehend die Akzeptanz des eingesetzten Testverfahrens erhöht. Es gibt diverse psychologische Unterschiede zwischen den unterschiedlichen Durchführungsarten (Online vs. Papier), wie beispielsweise Sorgen vor technischen Problemen oder auch das Nicht-Vorhandensein eines menschlichen Ansprechpartners im Verlauf der Testdurchführung, welche sich auf den Teilnehmenden und dadurch auch auf die erzielte Ergebnishöhe auswirken können. Zu diesem Ergebnis kommt auch die aktuelle Forschungsstudie und es kann festgehalten werden, dass eine Durchführung kognitiver Tests in der Papier-Version tatsächlich zu einem Anstieg der Testleistung führt. Übungseffekte bei mehrfacher Durchführung des Tests scheinen hingegen kaum relevant zu sein und haben keinen nachweislichen Einfluss auf die Testergebnisse. So kann erwartet werden, dass beispielsweise auch bei Wiederholern eines diagnostischen Prozesses bei erneuter Durchführung des Tests keine Übungseffekte und damit höhere Ergebnisse zu erwarten sind. Diese Erkenntnisse liefern wichtige Anhaltspunkte für die berufliche Eignungsdiagnostik, die im Rahmen der Konstruktion und Durchführung diagnostischer Prozesse zu berücksichtigen sind, um den Prozess optimal zu gestalten.

Falls Sie mehr zu unseren onlinebasierten kognitiven Tests erfahren möchten, kommen Sie gerne auf uns zu!

Literatur

Becker, S. M. (2025). Effekte von Papier- und Online-Durchführung kognitiver Tests auf Ergebnishöhe.

Schmidt, F. L., & Hunter, J. E. (1998). The validity and utility of selection methods in personnel psychology: Practical and theoretical implications of 85 years of research findings. Psychological Bulletin, 124(2), 262–274. https://doi.org/10.1037/0033-2909.124.2.262

Salgado, J. F., Anderson, N., Moscoso, S., Bertua, C., & De Fruyt, F. (2003). International validity generalization of GMA and cognitive abilities: A European Community meta‐analysis. Personnel Psychology, 56(3), 573-605.

Sackett, P. R., Zhang, C., Berry, C. M., & Lievens, F. (2021). Revisiting meta-analytic estimates of validity in personnel selection: Addressing systematic overcorrection for restriction of range. Journal of Applied Psychology, 107(11), 2040–2068. https://doi.org/10.1037/apl0000994

Brooklynmaxx GmbH. (2020). KTK-N: Kölner Test zur kognitiven Kompetenz – numerisch: Handbuch psychologische Testverfahren. Brooklynmaxx GmbH

Steiner, H. (2009). Online-Assessment: Grundlagen und Anwendung von Online-Tests in der Unternehmenspraxis. Berlin Heidelberg: Springer. https://doi.org/10.1007/978-3-662-68684-3

Schmidt-Atzert, L., Krumm, S., & Amelang, M. (2021). Psychologische Diagnostik. Berlin Heidelberg: Springer. https://doi.org/10.1007/978-3-662-61643-7

Krause, D. E. (2017). Personalauswahl. Wiesbaden: Springer Fachmedien. https://doi.org/10.1007/978-3-658-14567-5

Ruiz, S., Chen, X., Rebuschat, P., & Meurers, D. (2019). Measuring individual differences in cognitive abilities in the lab and on the web. PLOS ONE, 14(12), e0226217. https://doi.org/10.1371/journal.pone.0226217

Prisacari, A. A. (2017). Measuring the testing mode in general chemistry: The effect of computer versus paper mode on test performance, cognitive load, and scratch paper. https://doi.org/10.31274/etd-180810-5023

Clariana, R., & Wallace, P. (2002). Paper–based versus computer–based assessment: Key factors associated with the test mode effect. British Journal of Educational Technology, 33(5), 593–602. https://doi.org/10.1111/1467-8535.00294

Bunderson, C. V., Inouye, D. K. & Olsen, J. B. (1988). THE FOUR GENERATIONS OF COMPUTERIZED EDUCATIONAL MEASUREMENT. ETS Research Report Series, 1988(1). https://doi.org/10.1002/j.2330-8516.1988.tb00291.x

Mead, A. D., & Drasgow, F. (1993). Equivalence of computerized and paper-and-pencil cognitive ability tests: A meta-analysis. Psychological Bulletin, 114(3), 449–458. https://doi.org/10.1037/0033-2909.114.3.449